Reino Unido desarrolla sistema para predecir asesinatos. Polémica por el uso de datos sensibles y sesgo racial

El Ministerio de Justicia del Reino Unido está trabajando en un controvertido proyecto de inteligencia artificial que busca predecir quiénes podrían cometer homicidios en el futuro.

La iniciativa, aunque presentada como herramienta de prevención, ha sido fuertemente criticada por su potencial discriminatorio

El gobierno defiende que la iniciativa tiene fines preventivos, organizaciones defensoras de los derechos civiles alertan sobre los peligros éticos y sociales que representa, especialmente en cuanto al uso de datos sensibles y su posible sesgo discriminatorio.

Un sistema para predecir homicidios

El llamado “Proyecto de Predicción de Homicidios”, ahora renombrado como “Compartir datos para mejorar la evaluación de riesgos”, busca analizar información personal de cientos de miles de personas para identificar características que podrían estar asociadas con futuros delitos violentos.

Esta iniciativa, liderada por el Ministerio de Justicia junto a la Policía Metropolitana, la Policía de Greater Manchester y el Ministerio del Interior, utiliza algoritmos de inteligencia artificial alimentados con datos oficiales, incluyendo antecedentes penales, historial de salud mental, conductas autolesivas, adicciones, discapacidades y contacto previo con la policía, incluso si la persona no ha sido condenada por delito alguno.

Documentos obtenidos por la organización de vigilancia civil Statewatch a través de solicitudes de acceso a la información revelan que el proyecto incluye información de entre 100.000 y 500.000 individuos, algunos de los cuales solo han sido víctimas o testigos, o han solicitado ayuda a las autoridades.

Críticas por sesgo y discriminación

- Los detractores del proyecto, entre ellos investigadores de Statewatch, lo califican de “escalofriante y distópico”. Alegan que este tipo de sistemas no solo están construidos sobre datos provenientes de instituciones con historial de racismo estructural, sino que también perpetúan sesgos contra comunidades racializadas y personas de bajos ingresos.

- Investigaciones previas del propio Ministerio de Justicia han demostrado que herramientas predictivas similares, como el sistema OASys utilizado para evaluar la reincidencia, son menos precisas con personas negras y de origen mixto en comparación con personas blancas. Esto plantea dudas sobre la equidad de un sistema que podría influir en decisiones judiciales o penitenciarias.

¿Para qué se usarán estos datos?

- Según el gobierno, el sistema aún se encuentra en fase de investigación y no se utiliza de manera operativa. Su propósito, explican, es evaluar si el uso de nuevas fuentes de datos puede mejorar las herramientas de evaluación de riesgos ya existentes en los servicios penitenciarios y de libertad condicional.

- Sin embargo, los documentos revelan una intención clara de avanzar hacia una posible implementación futura del sistema. La preocupación crece al saber que se consideran datos extremadamente sensibles, como la salud mental o experiencias pasadas de violencia doméstica, como elementos con “alto poder predictivo”.

Análisis: ¿Seguridad o vigilancia encubierta?

- El desarrollo de este tipo de herramientas plantea profundas preguntas éticas sobre la privacidad, la presunción de inocencia y la discriminación institucionalizada. Si bien es comprensible que las autoridades busquen métodos más eficaces para prevenir delitos graves, el enfoque predictivo basado en algoritmos puede acabar castigando a personas por factores fuera de su control, como su lugar de residencia, su historial de salud o su etnia.

- Comparado con otros países, como Estados Unidos, donde tecnologías similares han sido criticadas por reproducir desigualdades raciales, el Reino Unido parece seguir un camino similar, sin atender suficientemente a los riesgos sociales y morales que implica este tipo de automatización.

- Un enfoque más humano podría priorizar la inversión en servicios de apoyo social, salud mental y programas comunitarios antes que depender de modelos algorítmicos que, hasta la fecha, han demostrado más errores que aciertos en este ámbito.

Fuentes Noticias:

Crédito Imágenes:

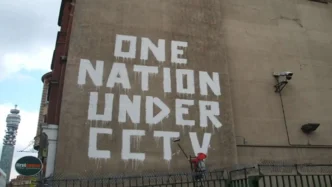

“One Nation under CCTV” por Mike Peel, licencia CC BY-SA 2.0, vía Wikimedia Commons.

Ver imagen en Wikimedia Commons

“British working class” por Lewis W. Hine, dominio público, vía Wikimedia Commons.

Ver imagen en Wikimedia Commons

English

English Español

Español